(Partnerský příspěvek)

Nějaký druh Network Attached Storage (NAS) dnes už potřebuje prakticky každý uživatel IT, ať se jedná o domácího uživatele, vědecké pracoviště nebo firmu jakékoli velikosti. A každý má právě teď problém s jeho kapacitou, samozřejmě relativní své důležitosti. A problém s kapacitou díky povaze zařízení NAS téměř vždy znamená i problém s výkonností. Obě tato slova, kapacita a výkon, jsou v IT žargonu pouze synonymy pojmu finanční náklady. Je tedy řešením NAS problému jedině pravidelné vypisování objednávky?

Proč vlastně používáme NAS?

Důvod k nasazení NASu by se dal byznys jazykem popsat jako outsourcing. Připomeňme si, že outsourcing volí manažeři pro ty činnosti, které nejsou „core businessem“ a u kterých je veliká šance, že je outsourcer bude provozovat levněji. Zároveň čekáme, že řízení outsourcované činnosti bude jednodušší, očekáváme smluvně zaručenou kapacitu a kvalitu (SLA).

Analogicky outsourcing filesystému znamená, že se procesorová kapacita serverů uvolní pro compute činnosti a také by mělo ubýt starostí se správou. Dobrými kandidáty na outsourcing jsou tedy například soubory s nestrukturovanými daty – home adresáře uživatelů podnikové LAN, sdílené adresáře, mezivýsledky HPC výpočtů anebo soubory, do kterých hypervisory ukládají virtuální servery.

Proč to tak často nefunguje?

Většina NAS appliancí je založená na klasickém Intel PC motherboardu, na kterém běží vytuněná verze klasického OS, spouštějící souborové služby a je doplněná o více či méně uživatelsky příjemné management rozhraní. Když se to nepovede, nahradili jsme CPU, disky a OS 1:1. (Takto ostatně naráží i skutečný outsourcing.)

Díky soustředění velké kapacity a velkého počtu uživatelů do jednoho místa může dojít k problémům, které se při distribuovaném ukládání neobjevují: sekvenční charakteristika přístupu z mnoha různých vláken se složí v random výslednici a obrovské množství operací s metadaty zatíží CPU.

Metadata

Zatímco objektová zařízení jako je Hitachi Content Platform pracují s popisnými metadaty, pomocí nichž třídí obrovská množství datových objektů, metadaty v kontextu NAS se myslí strukturální metadata vypovídající o mapování datového objektu (souboru) na datové bloky a administrativní metadata určující práva k objektům/souborům. U neoutsourcovaného filesystému jsou strukturálními metadaty souboru například strom inodů a administrativními metadaty například ACL. Vzhledem k povaze souborových protokolů NFS a CIFS je práce s metadaty kritická pro výkon „outsourcingového centra“ – NASu. Každý klient, který montuje sdílený filesystém, si jako první operaci udělá ‘ls’ nebo ‘dir’. Další sken adresářové struktury přijde při startu aplikace, při antivirovém skenu, přihlášení, odhlášení, zálohování, každé kontrole volného místa... Dalo by se říci, že v běžném provozu NASy nedělají prakticky nic jiného než ‘dir‘.

Unikátní řešení – Hitachi NAS

Hitachi NAS (HNAS) používá hardwarovou akceleraci NFS a CIFS operací. Operace s metadaty a přesun datových bloků mezi síťovým rozhraním NAS a blokovým rozhraním jeho disků jsou prováděny nikoli Intel CPU na motherboardu, ale paralelně soustavou čtyř FPGA (Field Programmable Gate Array), česky programovatelných hradlových polí. Motherboard CPU je pak k dispozici pro management a data management funkce. Použití FPGA místo ASIC (zákaznického integrovaného obvodu) má své výhody, jednoznačně převládající nad jedinou nevýhodou, kterou je relativně nižší výkon programovatelných hradel oproti hradlům napevno zapojeným při výrobě.

Výhody FPGA v HNASu samozřejmě souvisí s jejich programovatelností. Porovnání se nabízí – srovnejte si kvalitní dumbphone s vaším smartphonem. Ano, obojím se dá telefonovat a psát zprávy, ale smartphone má navíc spoustu různých „appek“ k všemožným úkolům.

Aplikace na HNASu

Nejzajímavější aplikací je deduplikace datových bloků. Ostatní NASy zatěžují jediný druh procesoru, který mají k dispozici výpočtem hashů, vyhledáváním v hash indexu a porovnáváním nalezených datových bloků, které zamezí kolizím hashů. HNAS počítá silný hash SHA-256 jaksi mimochodem, při průchodu datových bloků přes FPGA, ať jsou zrovna ukládány nebo čteny. Protože při použití 256bitového hashe nehrozí kolize, není potřeba provádět porovnání dat před deduplikací (kdo by přesto chtěl, může ho zapnout). Intel CPU se procesu deduplikace dat účastní pouze při vyhledávání hashe v indexu, což je svou povahou přesně taková činnost na kterou bylo navrženo.

CPU se procesu deduplikace dat účastní pouze při vyhledávání hashe v indexu, což je svou povahou přesně taková činnost na kterou bylo navrženo.

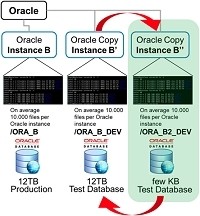

Běžně požadovanou aplikací jsou snapshoty a klony. Při bližším zkoumání je jasné, že jsou to na metadata náročné operace. Pro zálohování, ochranu a testování například VM a Oracle instancí jsou ale klony a snapshoty nezbytné.

Obrázek: úsporné a rychlé klony Oracle

Další oblíbenou aplikací je tierovaný filesystém, tedy oddělení místa uložení metadat od místa uložení datových bloků. Strukturální metadata, zpracovávaná FPGA, se ukládají na SSD, což dále zrychluje skeny adresářů. Datové bloky mohou skončit na běžných rotujících discích a nejžádanější operace jsou provedeny rychostí křemíku. Tuto funkci lze rozšířit i o tiering do důvěryhodného archivu HCP, do on-premise, privátního nebo i veřejného cloudu a také na LTO pásku s LTFS.

Naprostou novinkou je Universal Migrator, který umí na HNAS automaticky, transparentně a bez downtime odmigrovat existující NASy a fileservery.

A to vše pěkně hardwarově. Tak, a pojďme se bavit o tom, jaké má kdo vychytané appky a jak mu běhají :-)

Vladimír Blažek

Senior Solutions Consultant, File & Content Solutions, Hitachi Data Systems